HINWEIS: Füge hier oben direkt den YouTube-Block ein und verlinke dein Video. Der Leser soll sofort schauen können.]

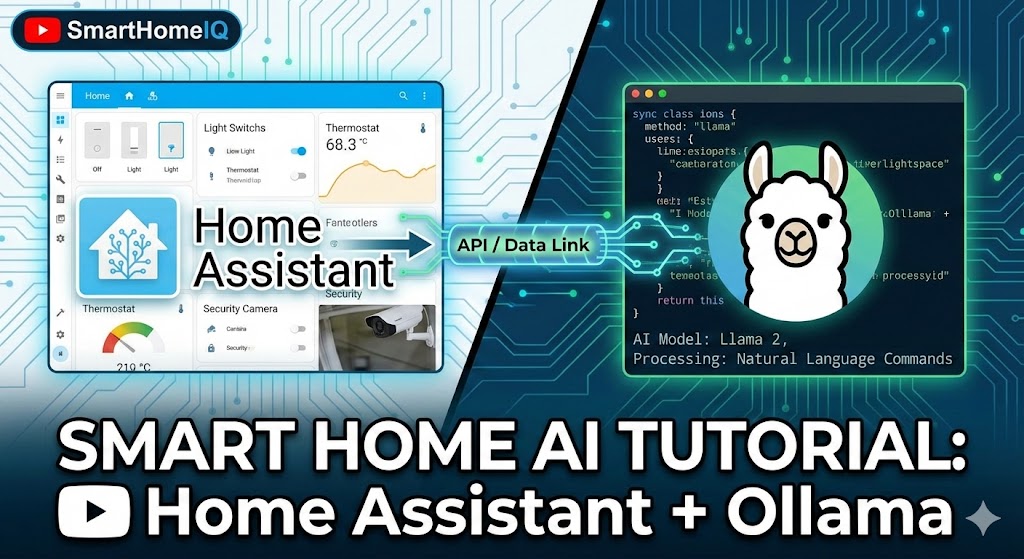

In diesem Video zeige ich dir, wie wir eine lokale KI (Ollama) direkt in Home Assistant integrieren, um komplexe Automatisierungen per Sprache zu steuern – komplett ohne Cloud.

Warum machen wir das?

Klassische Sprachassistenten verstehen oft den Kontext nicht. Mit einem LLM (Large Language Model), das lokal auf deiner Hardware läuft, hast du keine Latenz zum Internet und volle Privatsphäre.

Voraussetzungen

- Einen laufenden Home Assistant (siehe [Link zum Grundlagen-Video])

- Hardware mit genug RAM oder eine dedizierte GPU (NVIDIA)

- Das Add-on „Ollama“ installiert

Schritt 1: Docker Container aufsetzen

Wir nutzen Docker Compose, um den Service bereitzustellen. Hier ist meine Konfiguration, die stabiler läuft als das Standard-Add-on:

[HINWEIS: Hier fügst du einen Code-Block ein]

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ./ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: 1

capabilities: [gpu]

Schritt 2: Integration in Home Assistant

Gehe in deine configuration.yaml und füge folgenden Block hinzu. Damit sagen wir HA, wo das Gehirn sitzt.

conversation:

- platform: ollama

url: "[http://192.168.1.50:11434](http://192.168.1.50:11434)"

model: "llama3"

Das Ergebnis

Nach dem Neustart kannst du im Assist-Menü nun „Ollama“ als Agent auswählen. Probier es aus mit dem Befehl: „Schalte alle Lichter im Wohnzimmer aus, aber lass die Stehlampe auf 10% gedimmt.“

Hat dir das Tutorial geholfen? Dann lass auf YouTube einen Daumen da! Fragen gerne hier in die Kommentare oder direkt unter das Video.

Bis zum nächsten Mal!